https://fullstackdeeplearning.com/spring2021/lecture-9/

Full Stack Deep Learning

Hands-on program for software developers familiar with the basics of deep learning seeking to expand their skills.

fullstackdeeplearning.com

너무 어려워서 기억나는 것만 적어봄.

이건 우리가 이미 하고있지만 그걸 인지하지 못하는 상황을 말하는거다. 이런 일이 일어나지 않게 ai 윤리를 배우는 듯. 이게 뭐냐면 데이터에 백인들만 있어서 인종차별적인 모델을 만들 수 있는데 생각해보지 않으면 맹점으로 넘어갈 수 있는걸 생각해보란 뜻.

인공지능이 사람 일자리 빼았네 어쩌구 하는거.

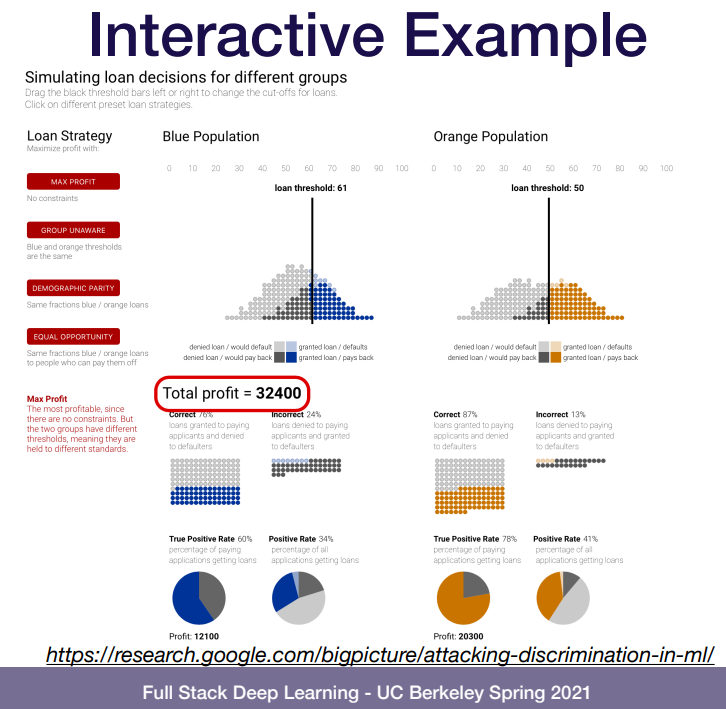

인력 고용 ai 모델을 만든다고 하자. 사람은 편견을 무의식적으로라도 가지기 때문에(백인이 많음, 인도애들 말빨만 좋음 등) 데이터에도 그런 편견이 들어가고 모델도 그런 데이터로 학습한다. 그럼 모델도 자연스럽게 편견이 생길거고 이걸로 데이터를 다시 만들때도 편견이 들어간 모델로 다시 학습된다.

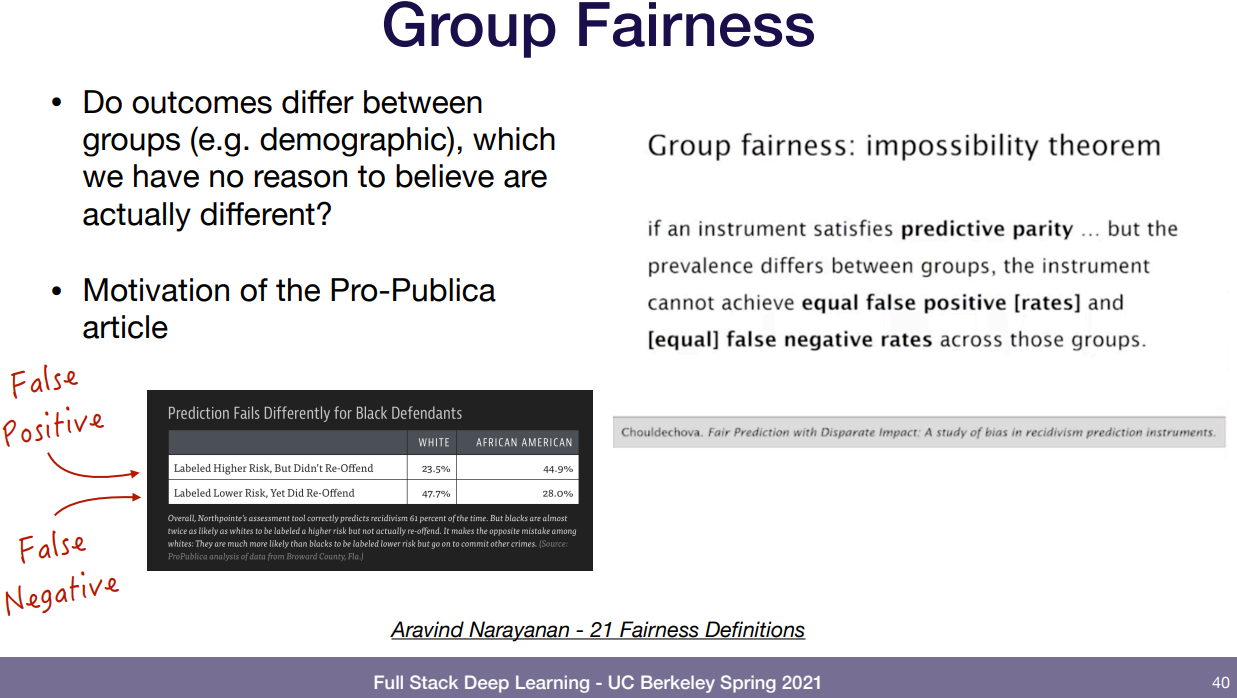

이건 이해 못했는데 classification에서 정답 metric은 TP, TN, FP, FN가 있다. 정확도는 TP/TP+FP 이고 민감도는 TP/TP+FN 인데 둘 중 어디에 무게를 둘 지는 프로젝트에 따라, 사람에 따라 다른걸 아는게 중요하다. 어떤 사람은 둔감하고 어떤 사람은 까다롭다. 그런 얘기 한 것 같음.

사람을 감지하는 모델 같은 경우 백인들이 개발하는 경우가 많아 백인들 위주 데이터 등으로 편향되는 경향이 있다. 그래서 감지하는게 백인은 되는데 흑인은 안되는 경우 등. 그런 문제를 고치고자 하는거임.

성별로도 나뉘는데 ceo 치면 중년 남자 사진만 나오는 등. 요샌 골고루 잘 나옴.

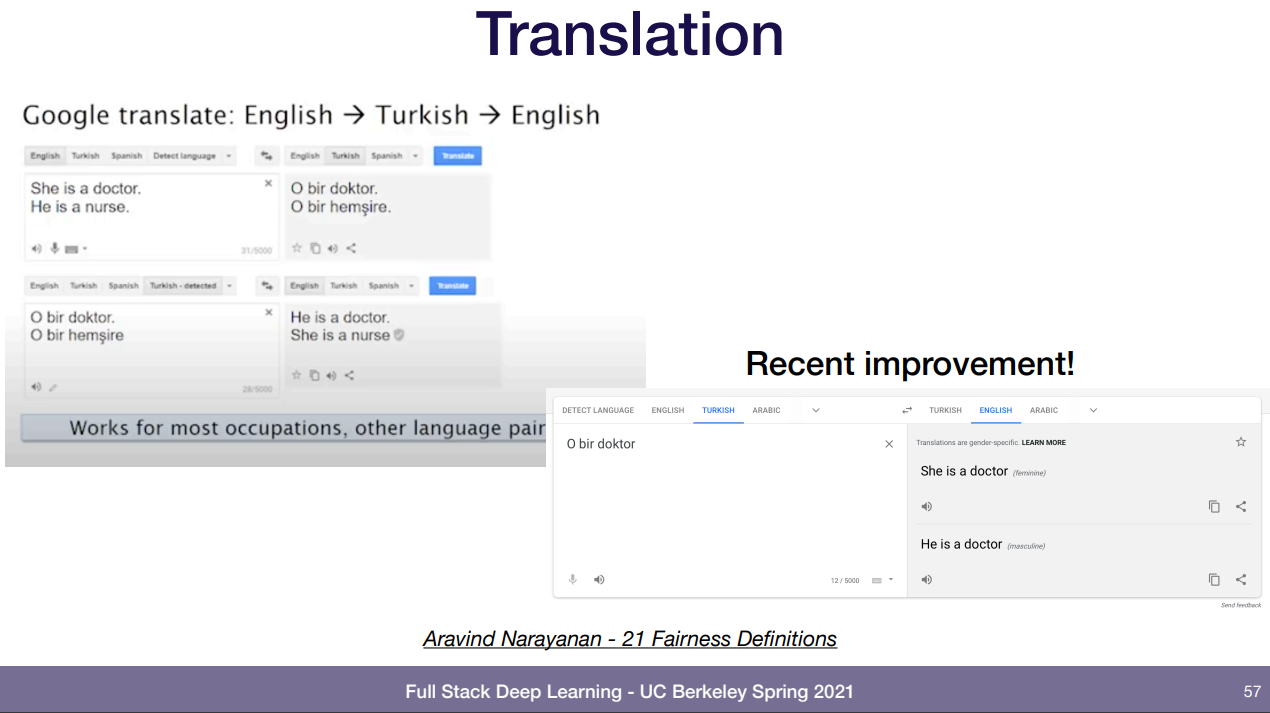

번역도 이젠 선택할 수 있도록 달라짐. 저게 뭐냐면 터키어는 성별 주어가 없어서 영어를 터키어로 번역한 걸 재번역 하면 편견에 따라 여자 의사, 남자 간호사 였던게 남자 의사, 여자 간호사려 바뀌어 있다. 그래서 이런건 선택하게 한다.

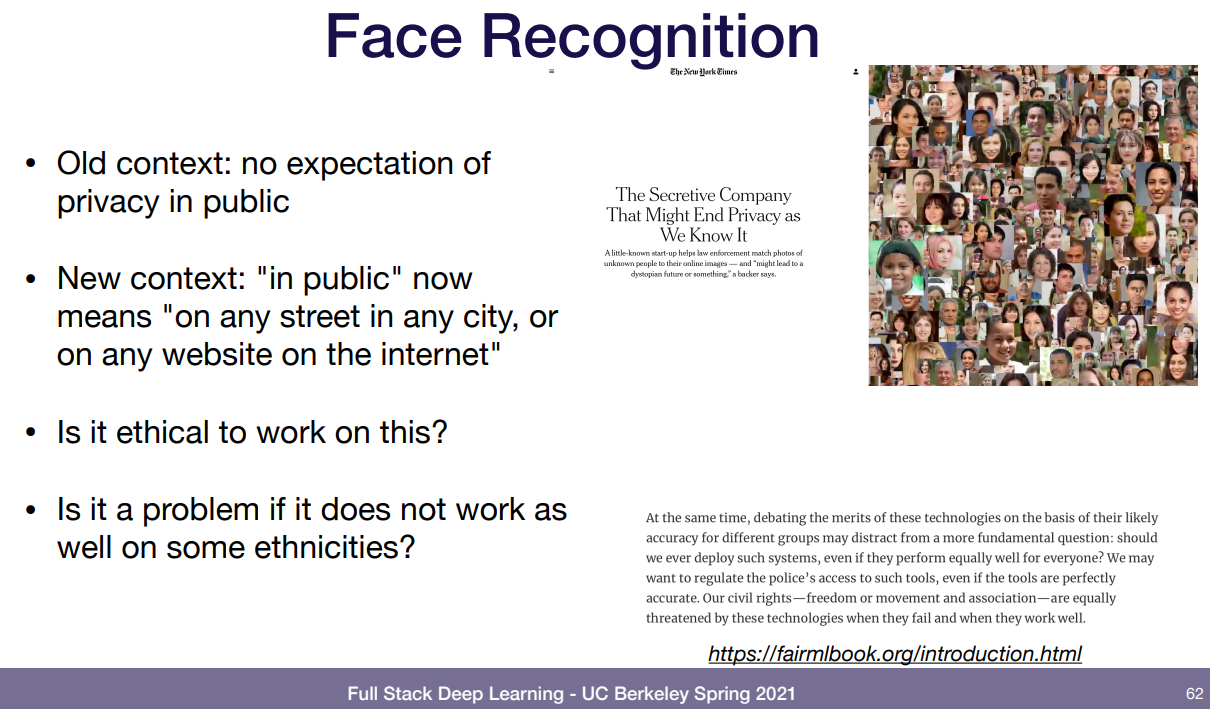

얼굴 감지도 감지인데 여기서 공공장소(public)에 대한 정의를 다시 생각해 볼 필요가 있다.

옛날엔 공공장소라 함은 그냥 길거리나 백화점 등 사람들이 많이 모여있는 것이다. 이 공공장소에 나간다는 것은 내 자신이 다른 사람에게 노출 될 수 있고 그것을 허용한다는 암묵적 동의다.

하지만 요즘의 공공장소는 인터넷 공간도 포함된다. 그럼 SNS등 인터넷에 사진을 올리는 것 또한 외부의 사람들에게 자신의 얼굴이 노출된다는 걸 암묵적으로 동의한 것이 아닌가? 근데 이걸 동의하지 않는 사람이 있다면? 이런 문제인듯.

이런 윤리문제는 특히 의학에서 발전한 듯 하다. pdf 보면 책이랑 강의들 추천해줌.

'강의 > fullstackdeeplearning_spring' 카테고리의 다른 글

| Lecture 11: Deployment & Monitoring / Deployment (0) | 2022.05.01 |

|---|---|

| Lecture 10: Testing & Explainability (0) | 2022.04.30 |

| Lecture 8: Data Management (0) | 2022.03.20 |

| Lecture 7: Troubleshooting Deep Neural Networks (0) | 2022.03.12 |

| Lecture 6: MLOps Infrastructure & Tooling (0) | 2022.03.04 |